- A la UNE

- ACTUALITE SCIENTIFIQUE et TECHNOLOGIQUE

- BLOG

- PRESENTATION

- CONSCIENCE

- PLANETE VIVANTE

- SCIENCES

- Sciences et histoire

- Science et politique

- Science/conscience

- Le COVID-19

- COVID-19 - Journal d'une pandémie - 1 -

- COVID-19 - Journal d'une pandémie - 2 -

- COVID-19 - Journal d'une pandémie - 3 -

- COVID-19 - Journal d'une pandémie - 4 -

- COVID-19 - Journal d'une pandémie - 5 -

- COVID-19 - Journal d'une pandémie -6 -

- COVID-19 - Journal d'une pandémie - 7

- COVID-19 - Journal d'une pandémie - 8

- COVID -19 - Journal d'une pandémie - 9

- COVID-19 - Journal d'une pandémie - 10

- Arts et sciences

- L'homme debout

- Les débuts de la sagesse

- L'épopée scientifique

- Chimie, vivant... une si longue histoire !

- Introduction : 52 choses que je sais d'elle

- Sommaire

- 1 - Premiers pas

- I - A l'origine

- II - De la tetrasomia et l'alchimie à la chimie moderne

- III - al-kimiya

- IV - Alchimie : de l'aube à la fin de la Renaissance

- V - De l'(al)chimie à la chimie : une question de méthode ?

- VI - L'alchimie selon Newton, première partie

- VII - L'alchimie selon Newton, deuxième partie

- 2 - La chimie des Lumières

- XI - Chimie au siècle des Lumières - Introduction

- XII - Chimie au siècle des Lumières- Les affinités électives

- XIII - Diderot et la chimie

- XIV - Diderot - La chimie, pourquoi ?

- XV- Diderot chimiste

- XVI- La chimie et le Rêve de D'Alembert

- 3 - La chimie du vivant

- X - Chimie et Vivant - Introduction

- XIX - La génération spontanée

- XX - Fermentation : duel à 3 !

- XXI - Stéréochimie : clé du Vivant

- XXII - Homochiralité et origine de la vie

- XXIIc - Origine de la vie : état des lieux... provisoire

- XXIIb - Des biopolymères aux premiers organismes vivants

- XXIII- Stéréochimie et activité biologique

- XXIV - Chimie du cerveau - 1- Un cerveau, trois cerveaux, des cerveaux...

- XXV - Chimie du cerveau - 2 - Les neurotransmetteurs, messagers chimiques

- XXVI- Chimie du cerveau -3- Rôle des différents neurotransmetteurs

- XXXIV - Odorat, Odeurs et parfums

- XXXV- Bonnes et mauvaises odeurs

- XXXVI - Chimie et parfums

- XLIII - Chimie et couleur -1- De colore

- XLIV - Chimie et couleur -2- Couleurs végétales

- XLV - Chimie et couleur -3- : chimiothérapie et colorants

- XL- a - ADN, ARN, protéines

- XL- b - Chimie supramoléculaire

- XXXIX- Chimie et Synthetic Biology

- XLVI - Du génome au protéome

- 4 - Chimie et médecine

- VIII - Chimie et médecine : d'Hippocrate à Néron

- IX - Chimie et opium : voyages, voyages !

- XVII- Médecine et Chimie à Montpellier avant la Révolution

- XVIII - Le vitalisme de l'Ecole de Montpellier

- XXIX - Le médicament aujourd'hui

- XXVII - Autour de la sérotonine

- XXVIII - L'ocytocine

- XXX - Chimie, médecine, nanotechnologies

- L - Chimie et dopage -1- La chimie au service du dopage

- LI - Chimie et dopage - 2 - Les outils du chimiste contre le dopage

- XLIX - Image magnétique - 3 - de l'IRM au patient numérique

- 5 - La chimie moderne et ses hommes

- XXXI - Mendeleïev : un tableau de maître !

- XXXII - Mendeleïev : -2- Un chimiste russe au XIXème siècle

- XXXIII - Mendeleïev -3- Le fin mot de l'histoire

- XLI - Paul Sabatier, chimiste languedocien, prix Nobel 1912

- XLII - Victor Grignard, prix Nobel 1912

- XLVII - Image magnétique - 1 - Une histoire de spin

- XLVIII - Image magnétique - 2 - Mais que vient faire le chimiste dans cette galère ?

- 6 - Chimie : bonnes et mauvaises pratiques

- XXXVII- Du mauvais usage de la chimie

- XXXVIII- La chimie passe au vert

- Pour conclure

- Postface - Nylon by DuPont de Nemours

- Nylon... - Part A

- Nylon... - Part B

- Nylon... - Part C

- Nylon... - Part D

- La beauté des mathématiques

- Les sciences vers La Science

- La révolution numérique

- CRISPR-Cas9 : l'édition de gènes

- L'ombre de Frankenstein

- VOIR

- RECHERCHE, CONTACT

Intelligence artificielle et réseaux neuronaux

« Tenter de distiller l'intelligence dans une construction algorithmique peut s’avérer être le meilleur chemin pour comprendre le fonctionnement de nos esprits. »

— Demis Hassabis, Nature, 23 février 2012.

L'IA, une révolution scientifique en marche...

... seule capable de traiter et de comprendre l'avalanche de données

Dans tous les domaines scientifiques les chercheurs croulent sous les données, par exemple :

-en biologie avec le décryptage du génome, du protéome, du microbiome, du métabolome...

- en astronomie où les données recueillies se chiffrent en petabytes,

- dans les sciences sociales où l'analyse des données fournies par internet (Google traite des dizaines de pétaoctets par jour !) est devenu un véritable casse-tête.

- en médecine avec l'émergence du patient numérique,

- en chimie organique, où le traitement informatique traditionnel a largement échoué dans l'accompagnement des synthèses multi-étapes complexes,

...

Un ordinateur de grande capacité est capable de trier des données, mais sur un énorme échantillon il n'en dégagera pas la substantifique moelle ; surtout pour des systèmes complexes, difficiles à modéliser à l’aide des méthodes statistiques classiques, ou dans toutes les situations où il existe une relation non linéaire entre une variable prédictive et une variable prédite.

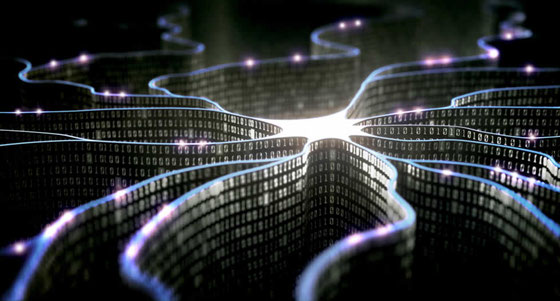

Pour cela les chercheurs, s'inspirant du fonctionnement du cerveau humain, ont imaginé des réseaux de neurones artificiels.

Les réseaux neuronaux sont capables de détecter les interactions multiples non linéaires parmi une série de variables d’entrée, ils peuvent donc gérer des relations complexes entre les différents types de variables.

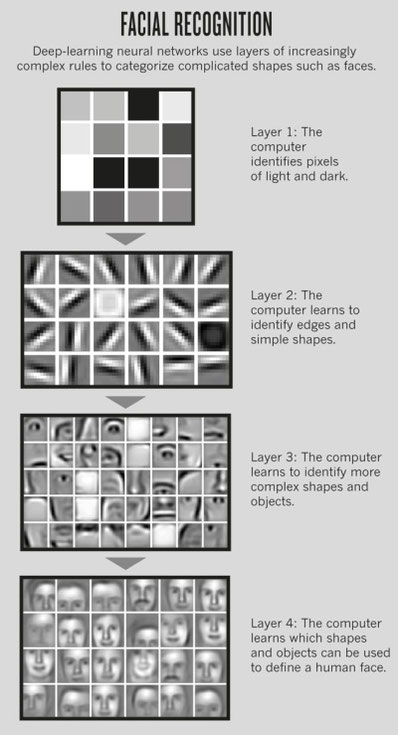

Ces réseaux sont composés de plusieurs couches de cellules reliées entre elles et formant une vaste toile. Un ensemble d'unités reçoit des éléments d'une entrée (par exemple des pixels pour une photo), effectue des calculs simples sur ces données, les transmet à la couche suivante et ainsi de suite. La dernière couche donne le résultat. Ce réseau est capable d'ajuster ses propres interconnexions, exactement comme cela se passe dans le cerveau humain lors de l'apprentissage.... Toute proportion gardée bien entendu (un réseau neuronal ne pourra pas à la fois conduire une voiture et faire une traduction, par exemple !).

En multipliant les couches, on aboutira à des modèles de plus en plus élaborés, on parle d'apprentissage profond (deep learning).

Il faut noter que Google est en pointe dans le domaine de l'IA, il développe par exemple une boite à outils de logiciels open source (Tensorflow).

Ces réseaux n'ont pas besoin d'être programmés ; ils apprennent seuls sur des modèles de plus en plus volumineux et complexes jusqu'à traiter des problèmes qui dépassent l'entendement humain ou qui nécessiteraient des temps d'analyse rédhibitoires.

Les résultats spectaculaires de l'IA dans le domaine scientifique se multiplient. Par exemple :

L' équipe de Martin Seligman (Université de Pennsylvanie) a prédit les taux de mortalité par maladie cardiaque au niveau d'un comté américain en analysant 148 millions de tweets !

Marwin HS Segler et al. utilise des réseaux récurrents de neurones comme générateurs de structures moléculaires dans la synthèse de médicaments de novo et obtient des résultats particulièrement prometteurs...

LIRE ceci : AI is changing how we do science.

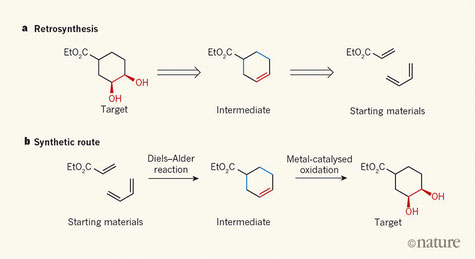

Synthèse chimique et AI

La chimie organique de synthèse consiste à élaborer des structures complexes à partir de briques élémentaires, en utilisant comme outil un ensemble de réactions chimiques rapportées par la littérature. Une sorte de bible des chimistes constamment enrichie, aujourd'hui constituée de milliers de références.

Depuis EJ Corey (Nobel de chimie 1990) et les années 60, le chimiste organicien a appris à rationaliser son travail en utilisant notamment une méthode rétrosynthétique, permettant de proposer des voies de synthèse raisonnables et optimisées.

A partir des années 80, l'informatique est venue aider le chercheur dans le débroussaillage du maquis des réactions chimiques applicables à la transformation d'un élément de structure moléculaire X en élément Y. Hélas, souvent ledit chercheur se trouve découragé par le nombre de solutions proposées.

Pourquoi ?

Tout simplement parce que la réaction chimique A qui permet de passer de X à Y est dépendante du contexte, c'est à dire des éléments de de structure Z, Z', Z'', ... qui sont également présents sur la molécule de départ, mais aussi des conditions opératoires (pH, température...), des problèmes stéréochimiques....

Pour chaque étape d'une synthèse, en gros, trois possibilités sont donc ouvertes :

- la réaction A peut s'appliquer directement,

- la réaction A pourra s'appliquer en masquant un élément Z, plusieurs éléments Z ou tous les éléments Z.

- la réaction A est inapplicable.

Ceci pour une seule étape... on imagine la difficulté quand on a affaire à une synthèse multistade qui comporte une dizaine d'étapes...

Les bases de données sont donc très utiles pour le chimiste, mais incapables de résoudre les équations à x dimensions et p paramètres, nécessaire aujourd'hui pour la réalisation d'une synthèse chimique.

(Même si quelques très lourds programmes sont maintenant proposés).

Photo JPL traitée par Deep Dream de Google, façon Van Gogh

Faut-il avoir peur de l'IA ?

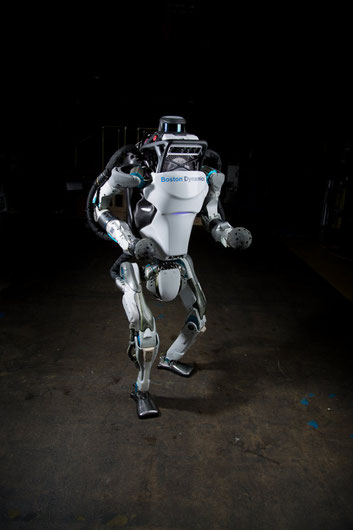

Le développement de l'intelligence artificielle accompagne les progrès faramineux de la robotique. Pour l'instant nous sommes encore loin des humanoïdes de science-fiction, capables de séduire une belle terrienne, mais les premiers pas sont édifiants.

Par exemple le robot Atlas d'Alphabet (Google), grâce à une vision stéréo sophistiquée et de multiples capteurs, a la possibilité de manipuler des objets dans son environnement et de se déplacer sur un terrain accidenté.

Plus généralement, il me semble clair que la révolution de l'IA nous conduit vers une société transhumaniste, où raison, science et technologie pourraient être déployées au service de la lutte contre la pauvreté, la maladie, le handicap et la faim dans le monde,

Cette approche fait peur car elle implique le dépassement des limitations biologiques et la prise de contrôle de leur évolution par les humains eux-mêmes.

Pourtant les progrès scientifiques et technologiques, boostés par l'IA, indiquent que dans moins de 50 ans l'humain augmenté sera parmi nous.

Faut-il le craindre ? Personnellement je partage le point de vue du célèbre auteur de science-fiction Isaac Asimov :

“I could not bring myself to believe that if knowledge presented danger, the solution was ignorance."

Je n'ai jamais crû que si la connaissance présentait un danger, la solution était l'ignorance

NOTE : 2 000 signataires, dont Elon Musk, patron de SpaceX, Tesla..., ont adopté un guide de référence pour un développement éthique de l'intelligence artificielle. Ces « 23 principes d'Asilomar » s'inspirent un peu des 3 lois de la robotique de l'écrivain Isaac Asimov.

Aujourd'hui, en réalité, le risque majeur de la robotisation est une perte massive d'emplois peu qualifiés.

Les chiffres sont contradictoires. En France, le Conseil d'Orientation pour l'Emploi (COE, rattaché au premier ministre) estime à moins de 10% les postes de travail directement menacés aujourd'hui par l'automatisation (agents d'entretien, ouvriers qualifiés des industries de process, ouvriers non qualifiés de la manutention en tête).

D'autres publications sont beaucoup plus inquiétantes.

Une étude très pointue, réalisée à Oxford en 2013, indique que la part des emplois impactée par les évolutions technologiques pourrait varier entre 45 et 60% dans les états membres de l’Union Européenne. En France, le risque est estimé à 49,54%

En France UN emploi sur DEUX sera à court ou moyen terme menacé par cette révolution technologique.

Or nos systèmes publics d’éducation et de formation -initiale et continue- ne sont clairement pas adaptés à la mutation en cours.

Il est urgent de revoir l'organisation et le contenu des études dans notre pays, si l'on veut compenser, au moins en partie, la perte de plusieurs millions d'emplois dans les 10 ans à venir.

Exemples de robotisation en cours de développement :

* Une étude , menée par l'Organisation internationale du travail, indique que jusqu'à 137 millions de travailleurs à travers le Cambodge, l'Indonésie, les Philippines, la Thaïlande et le Vietnam - environ 56% de la main-d'œuvre totale de ces pays - risquent d'être remplacés par des robots, en particulier les travailleurs de l'industrie manufacturière du vêtement.

** Un robot australien est capable de construire un mur de briques 10 fois plus vite qu'un maçon.

*** Un fabricant suédois a conçu une trayeuse qui propose ses services aux vaches selon leur désir !

LIRE : Robots will destroy our jobs – and we're not ready for it

Robotique et neurosciences

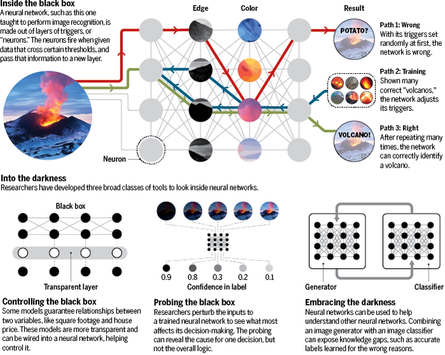

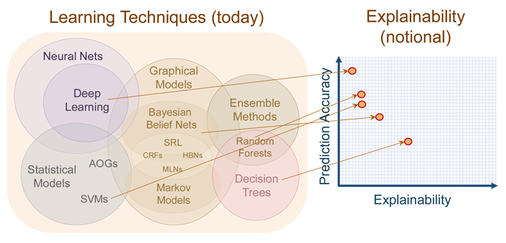

Voila qui ne va pas rassurer les populations frileuses devant les avancées de la science : on sait élaborer des réseaux neuronaux... mais on ne sait pas comment ils fonctionnent. Une vraie boite noire !

Comment comprendre que puisse être identifiée la forme d'un visage par une machine que l'on a gavée d'images d'objets hétéroclites ???

Il était donc urgent qu'émergent les neurosciences de l'intelligence artificielle !

Actuellement on développe des outils pour pénétrer l'esprit de la machine et donc l'améliorer. Les chercheurs rivalisent d'astuces et même de pièges pour craquer ces boites noires.

LIRE : How AI detectives are cracking open the black box of deep learning

Et si la recherche était totalement robotisée ?

Et si l'IA conduisait à la perte de nos jobs de chercheurs ?!

Dans la revue Science, John Bohannon qui décrit sa visite dans l'entreprise Zymergen à Emeryville (Californie), se pose la question.

Ce laboratoire de biotechnologie utilise toute une série de robots à vocation multiples pour, in fine, produire des "microbes" susceptibles d'intervenir dans la production de biocarburants, plastiques ou médicaments.

Ce type de laboratoire est courant, ce qui l'est moins c'est la façon dont la manipulation génétique est conduite à Zymergen où " ... pour interpréter des données, produire des hypothèses et planifier des expériences, le but suprême doit-être de se débarrasser de l'intuition humaine ", donc d'utiliser des robots intelligents. Faire du criblage à haut débit contrôlé par l'IA en quelque sorte.

Heureusement ce travail ne concerne qu'une petite partie des recherches dans cette interface chimie-biologie moléculaire-microbiologie-informatique (la fermentation microbienne en chimie "pèse" quand même 160 milliards de dollars !), car il est frustrant de ne pas comprendre "comment ça marche" !

Avant de conduire, dans de longues années, à la déshumanisation des laboratoires, l'IA peut au contraire apporter une aide très précieuse au chercheur, à tous les niveaux, de l'idée à la réalisation et à la publication des résultats :

- en triant de façon pertinente une bibliographie qui peut représenter des centaines voire des milliers d'articles,

- en suggérant des pistes de recherche,

- en proposant des protocoles expérimentaux,

- en pilotant des robots pour exécuter des tâches répétitives,

- en compilant et confrontant les résultats du laboratoire de toute nature...

...mais, pour l'instant, sans bannir l'intuition humaine, qui reste à la base des découvertes les plus innovantes.

L'apprentissage automatique

Pour résumer brièvement ce qu'est l'apprentissage machine on peut citer Arthur Samuel : «[l'apprentissage de la machine est le] champ d'étude qui donne aux ordinateurs la capacité d'apprendre sans être explicitement programmé".

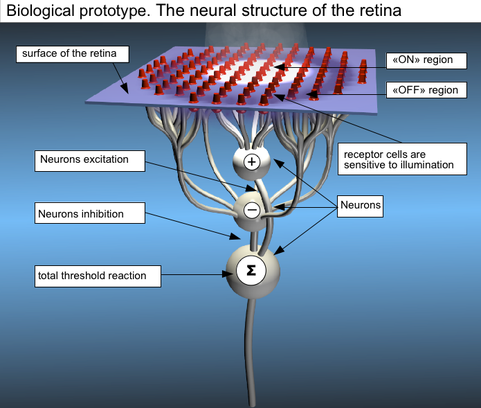

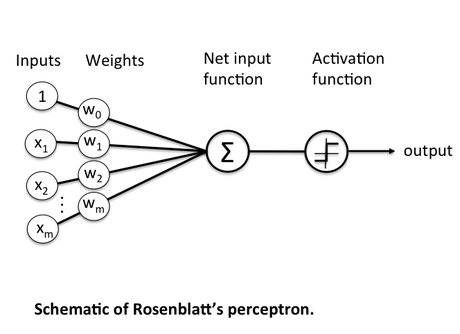

L'origine de la création d'un réseau neuronal artificiel tient à l'analogie de fonctionnement d'un neurone (ci-dessous, à gauche) et d'un perceptron (à droite).

Un neurone biologique peut être considéré comme la sous - unité d'un réseau de neurones dans le cerveau. Des signaux de grandeurs variables arrivent aux dendrites. Ces signaux d'entrée sont ensuite accumulées dans le corps cellulaire du neurone. Si le signal résultant atteint un certain seuil, un signal de sortie est généré qui sera transmis par l'axone.

Avec le perceptron de Frank Rosenblatt (1957), il s'agit de trouver un algorithme déterminant les poids respectifs de signaux d'entrée pour aboutir à une fonction capable ou non de générer un signal. C'était un système mono-couche qui n'avait qu'une seule sortie à laquelle toutes les entrées étaient connectées.

Un quart de siècle plus tard on introduira la Rétro propagation (Rumelhart, Parker, Le Cun, 1985) c'est à dire de la "convergence d’un algorithme itératif d’adaptation des poids d’un réseau de neurones multi-couche" pour en venir à une théorie de l'apprentissage (Support Vector Machine, Vapnik, 1992).

Pour aller plus loin sur l'analogie neurone biologique/neurone artificiel

Des puces neuro-inspirées

Le deep learning, comment ça fonctionne ?

Avant de décrire le deep learning, il faut parler de l'apprentissage supervisé, une technique permettant aux machines d'apprendre.

Il s'agit d'une technique d'apprentissage automatique, où l'on cherche à produire automatiquement des règles, à partir d'une base de données contenant des exemples déjà validés.

Par exemple pour qu'un programme apprenne à reconnaître une voiture, la base de données contiendra des milliers d'images de voitures, mentionnées comme telles.

Le deep learning utilise lui aussi l'apprentissage supervisé, mais la structure de la machine, composée de milliers d'unités de neurones artificiels, va permettre d'aller beaucoup plus "profond" dans l'apprentissage.

Pour reconnaître une personne, par exemple, la machine décompose l'image : d'abord le visage, les cheveux, la bouche, puis elle ira vers des propriétés de plus en plus fines (une cicatrice par exemple).

A chaque étape, le réseau de neurones approfondit sa compréhension de l'image avec une finesse accrue.

Sur l'image de gauche on voit le résultat en reconnaissance faciale avec quatre couches.

Le programme de deep learning de Google s'appelle "Google Brain", il est est lancé en 2011. Dès 2012 il conduit à un résultat spectaculaire : après avoir analysé dix millions de captures d'écran non étiquetées sur YouTube, la machine découvre par elle-même le concept de chat !

« Ce qui est remarquable, c'est que le système a découvert le concept de chat lui-même. Personne ne lui a jamais dit que c'était un chat. Ça a marqué un tournant dans le machine learning », Andrew Ng, fondateur du projet Google Brain.

Depuis, Google Brain s'est attaqué à bien d'autres sujets impliquant l'intelligence artificielle et les réseaux neuronaux, du véhicule sans conducteur au jeu de go. Il était donc tout naturel que Google l'utilise pour améliorer son outil Google Translate.

Neuron-Art by Google

Enfin, j'ai évoqué par ailleurs le programme «DeepDream », qui permet de visualiser un processus de deep learning, avec des résultats étonnants. Les formes repérées, analysées et interprétées dans une images ont visuellement « augmentées » par le programme.

" Si un nuage ressemble un peu à un oiseau, le réseau va le faire ressembler encore plus à un oiseau ".

Un travail surréaliste conduisant à des formes qui se situent entre le rêve, le mirage et l’hallucination psychédélique ... Un rêve de machine !

Pour générer vos propres rêves de machines, voyez ICI

Néanmoins, les progrès de l'intelligence artificielle donnent plutôt des cauchemars à certains. Google à déjà mis en place un bouton rouge pour freiner les délires de quelques uns. Aussi, un partenariat sur l'éthique vient d'être finalisé entre quelques géants du web.

Voici une photo personnelle en réalité augmentée selon DeepDream de Google

Google DeepMind : nouvel exploit à Londres

"Google DeepMind est une entreprise britannique spécialisée dans l'intelligence artificielle, appelée à sa création DeepMind Technologies, fondée en 2010 par Demis Hassabis, Mustafa Suleyman et Shane Legg, rachetée en 2014 par Google."

Le coeur de métier de l'entreprise est la mise au point de réseaux neuronaux artificiels que j'évoque ci-dessous.

Ces réseaux sont très performants dans les tâches qui impliquent la reconnaissance de formes, mais encore limités pour l'exécution d'instructions qui nécessitent une logique de base et un raisonnement complexe. C'est évidemment un souci pour le développement de l'intelligence artificielle (AI), qui doit permettre l'exécution de tâches complexes avec une supervision humaine minimale.

Les chercheurs avancent néanmoins à grand pas et la victoire de leur machine AlphaGo face grand maître sud-coréen Lee Se-Dol, qui domine le jeu de Go depuis une décennie, a fait récemment sensation.

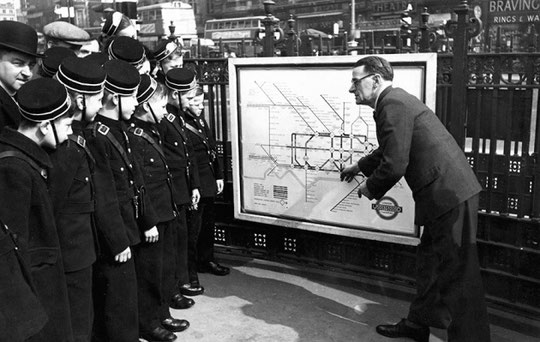

La publication dans le journal Nature du 12 octobre 2016, montre qu'un nouveau pas vient d'être franchi.

Avec leur " Differentiable neural computer " (ordinateur neuronal différentiable), ils ont réalisé un système capable d'appréhender la navigation dans le métro de Londres, sans aucune information préalable, en résolvant toute une série d'énigmes logiques.

En gros cela revient à reconstituer un puzzle totalement inconnu, avec un très grand nombre de pièces, sans avoir été programmé pour cela.

La traduction by Google

L'application de traduction de Google, "Google Translate", est très perfectible ! Vous êtes nombreux à vous arracher les cheveux devant la bouillie de mots crachée par le traducteur, pour une simple version anglais-français.

Pourtant le géant de Mountain View n'a pas lésiné sur les moyens pour arriver à ce médiocre résultat : ce sont des centaines de millions de traductions professionnelles qui ont été ingurgitées par les ordinateurs pour leur apprentissage, plus de 20 milliards de mots traités.

Voir vidéo ci-dessous.

Google a donc décidé d'employer les grands moyens : les réseaux neuronaux artificiels, domaine de l'intelligence artificielle où il est particulièrement actif.

Le 27 septembre dernier, Google a annoncé la mise en place d'un nouvel algorithme, entièrement basé sur le "Deep Learning" (apprentissage en profondeur).

Pour l'instant le système est opérationnel pour l'anglais et le chinois, le français est en test. Le taux d'erreur a été réduit de 60%, il pourrait descendre à 85%, niveau des erreurs humaines !

L'intelligence artificielle restera-t'elle imprévisible ?

L'intelligence artificielle, basée sur les réseaux neuronaux, conduit à des résultats stupéfiants... parfois imprévisibles. Et cela fâche beaucoup de chercheurs !

En fait ils se trouvent devant un éprouvant paradoxe : plus on obtient les résultats souhaités... moins ont sait les expliquer.

La revue Nautilus traite de ce vrai problème au moment où ces réseaux neuronaux artificiels sont de plus en plus utilisés, notamment dans les services de santé. L'Union Européenne vient ainsi d'établir un «droit à l' explication» , qui permet aux citoyens d'exiger la transparence des décisions algorithmiques.